用友暢捷通基于Flink構建實時數(shù)倉的挑戰(zhàn)與數(shù)據(jù)處理最佳實踐

用友暢捷通基于Flink構建實時數(shù)倉的挑戰(zhàn)與數(shù)據(jù)處理最佳實踐

引言

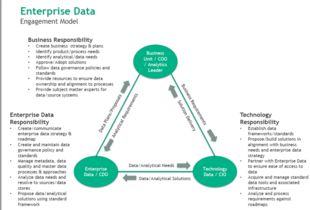

隨著企業(yè)數(shù)字化轉型的深入,對數(shù)據(jù)時效性的要求日益提高,傳統(tǒng)T+1模式的離線數(shù)倉已難以滿足實時業(yè)務洞察、風險監(jiān)控和智能決策的需求。用友暢捷通作為面向小微企業(yè)的云服務提供商,其產品線涵蓋財務、進銷存、CRM等多個領域,業(yè)務場景復雜,數(shù)據(jù)源多樣。為支撐其SaaS服務的實時分析與運營,用友暢捷通選擇基于Apache Flink這一先進的流處理引擎,構建其新一代實時數(shù)據(jù)倉庫。本文將探討在此過程中的核心挑戰(zhàn)與數(shù)據(jù)處理領域的最佳實踐。

面臨的挑戰(zhàn)

- 數(shù)據(jù)源異構性與復雜性:暢捷通服務的數(shù)據(jù)源包括來自不同SaaS模塊的業(yè)務數(shù)據(jù)庫(如MySQL、PostgreSQL)、日志文件、消息隊列(如Kafka)以及外部API數(shù)據(jù)。這些數(shù)據(jù)格式不一(結構化、半結構化),更新頻率和語義各異,實現(xiàn)統(tǒng)一的、低延遲的數(shù)據(jù)接入與融合是首要挑戰(zhàn)。

- 流批一體與數(shù)據(jù)一致性:業(yè)務需求往往需要結合實時流數(shù)據(jù)與歷史批量數(shù)據(jù)進行關聯(lián)分析。如何設計流批統(tǒng)一的數(shù)據(jù)模型和處理邏輯,并保證在分布式流處理場景下的精確一次(Exactly-Once)語義和數(shù)據(jù)最終一致性,是保障分析結果準確性的關鍵。

- 狀態(tài)管理與計算性能:實時數(shù)倉中涉及大量的有狀態(tài)計算,如窗口聚合、多維關聯(lián)、用戶行為序列分析等。Flink狀態(tài)的管理(包括狀態(tài)大小、訪問效率、容錯恢復)直接影響到系統(tǒng)的吞吐量、延遲和穩(wěn)定性。面對海量小微企業(yè)數(shù)據(jù),優(yōu)化狀態(tài)后端和計算邏輯至關重要。

- 維度表變更與實時關聯(lián):業(yè)務維度數(shù)據(jù)(如商品信息、客戶檔案)會發(fā)生變化。在實時流中如何及時、準確地關聯(lián)最新的維度信息(即“流”與“變”的維度表關聯(lián)),避免使用過時快照導致分析偏差,是一個經典難題。

- 運維與監(jiān)控復雜性:實時數(shù)據(jù)流水線是7x24小時運行的,對平臺的可觀測性、故障自愈能力、資源彈性伸縮以及版本升級等運維工作提出了極高要求。

數(shù)據(jù)處理最佳實踐

針對上述挑戰(zhàn),用友暢捷通在構建基于Flink的實時數(shù)倉過程中,出以下數(shù)據(jù)處理核心實踐:

- 分層架構與統(tǒng)一接入層:

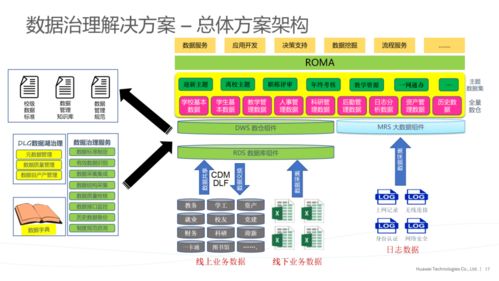

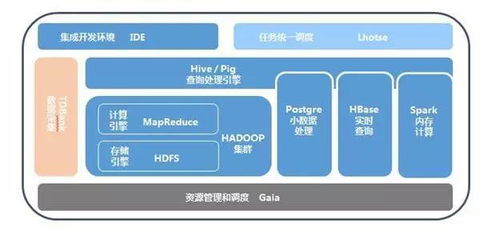

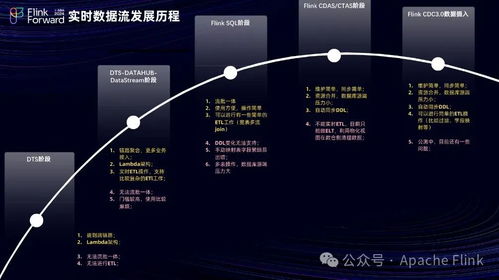

- 架構分層:采用經典的實時數(shù)倉分層模型,如ODS(操作數(shù)據(jù)層)、DWD(明細數(shù)據(jù)層)、DWS(匯總數(shù)據(jù)層)和ADS(應用數(shù)據(jù)層),通過Flink SQL或DataStream API實現(xiàn)各層間的數(shù)據(jù)流轉與加工。

- 統(tǒng)一接入:利用Flink CDC(Change Data Capture)技術,直接捕獲源數(shù)據(jù)庫的增量變更日志,將其作為流數(shù)據(jù)源,實現(xiàn)低延遲、全量+增量的數(shù)據(jù)無縫入湖/入倉。對于日志和消息隊列數(shù)據(jù),則通過Flink Connector高效接入。這簡化了數(shù)據(jù)采集流程,保證了數(shù)據(jù)的時序性和完整性。

- 流批一體SQL與動態(tài)表:

- 充分發(fā)揮Flink SQL作為流批統(tǒng)一處理語言的優(yōu)勢,使用相同的SQL語法處理無界流數(shù)據(jù)和有界批數(shù)據(jù)。將核心業(yè)務邏輯通過SQL定義,提升開發(fā)效率并降低維護成本。

- 利用Flink的“動態(tài)表”概念,將數(shù)據(jù)流視為一張持續(xù)更新的表,通過定義時間屬性和水印(Watermark)來處理亂序事件,并結合窗口函數(shù)完成復雜的時態(tài)計算。

- 狀態(tài)后端優(yōu)化與調優(yōu):

- 后端選型:對于狀態(tài)規(guī)模大、需要高性能讀寫的場景,采用RocksDB狀態(tài)后端,利用其磁盤存儲能力承載超大狀態(tài),并通過優(yōu)化RocksDB參數(shù)(如內存分配、壓縮策略)來提升性能。

- 狀態(tài)TTL與清理:為鍵控狀態(tài)(Keyed State)設置合理的生存時間(TTL),自動清理過期無用狀態(tài),防止狀態(tài)無限膨脹。

- 檢查點與保存點優(yōu)化:合理配置檢查點(Checkpoint)間隔和超時時間,采用增量檢查點減少每次快照的開銷。利用保存點(Savepoint)實現(xiàn)作業(yè)版本的安全升級和狀態(tài)遷移。

- 維度表實時關聯(lián)方案:

- 主流方案:對于變化緩慢的維度表,采用定期(如每分鐘)全量加載到內存(如使用Flink的

CachingTableSource)或分布式緩存(如Redis)中,流數(shù)據(jù)通過異步查詢進行關聯(lián)。

- 高級方案:對于變化頻繁的維度,將維度表自身也通過CDC技術轉換為變更流,使用Flink的“時態(tài)表函數(shù)”(Temporal Table Function)或“時態(tài)表連接”(Temporal Table Join)進行流式關聯(lián),確保每條事實記錄都能關聯(lián)到其發(fā)生時刻準確的維度版本,實現(xiàn)真正的“實時”拉鏈效果。

- 端到端數(shù)據(jù)一致性保障:

- 結合Flink的檢查點機制與下游支持兩階段提交(2PC)的存儲系統(tǒng)(如Apache Kafka事務、支持事務的數(shù)據(jù)庫),實現(xiàn)端到端的精確一次處理語義。例如,使用Flink-Kafka Connector的“精確一次”模式,確保數(shù)據(jù)從攝入到輸出不丟不重。

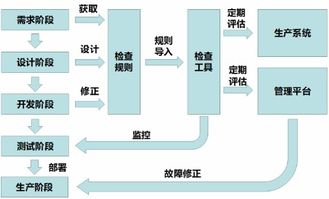

- 完善的監(jiān)控與運維體系:

- 指標監(jiān)控:全面收集Flink作業(yè)的指標(吞吐量、延遲、背壓、Checkpoint時長與大小、狀態(tài)大小等),并與Prometheus、Grafana等監(jiān)控系統(tǒng)集成,實現(xiàn)可視化監(jiān)控與報警。

- 日志與追蹤:集中管理作業(yè)日志,并集成分布式追蹤系統(tǒng)(如SkyWalking, Jaeger),追蹤數(shù)據(jù)在流水線中的處理路徑,便于快速定位瓶頸和故障。

- 平臺化運維:基于Kubernetes實現(xiàn)Flink作業(yè)的自動化部署、彈性擴縮容和高可用管理,提升整體運維效率。

與展望

用友暢捷通通過采用Apache Flink構建實時數(shù)倉,有效應對了海量、多源、實時數(shù)據(jù)處理的需求,為上層實時大屏、業(yè)務預警、智能推薦等應用提供了堅實的數(shù)據(jù)基礎。實踐表明,成功的關鍵在于:選擇流批一體的技術架構以簡化模型;利用CDC等技術實現(xiàn)低延遲數(shù)據(jù)集成;通過狀態(tài)管理和關聯(lián)優(yōu)化保障處理性能與準確性;并構建自動化的運維體系確保系統(tǒng)穩(wěn)定。隨著Flink流批一體生態(tài)的進一步成熟以及湖倉一體架構的演進,實時數(shù)倉將向著更實時、更智能、更統(tǒng)一的方向持續(xù)發(fā)展,為業(yè)務創(chuàng)造更大價值。

如若轉載,請注明出處:http://www.ahscgs.com.cn/product/72.html

更新時間:2026-01-20 16:48:08